🎬 Vedi qui l'intervista di Leopold con Dwarkesh Patel

🎧 Senti il podcast riassuntivo generato con NotebookLM:

Un numero crescente di ricercatori e ingegneri all’avanguardia nello sviluppo dell’intelligenza artificiale (IA) ritiene che l’intelligenza artificiale generale (AGI) potrebbe arrivare già nel 2027. Questa visione non si basa su clamore mediatico o sensazionalismo, ma su schemi coerenti osservati nelle prestazioni dei modelli, nelle dinamiche di scaling, nell’infrastruttura computazionale e nei flussi di capitale. Questi esperti osservano progressi rapidi nella disponibilità di hardware, guadagni continui nell’efficienza algoritmica e un’attenzione senza precedenti da parte dei principali laboratori di IA—tutti fattori che si stanno accelerando più velocemente del previsto.

Presi insieme, questi sviluppi indicano un orizzonte a breve termine in cui le macchine potrebbero eguagliare o superare le prestazioni di esperti umani in un’ampia gamma di compiti. Non si tratta di uno scenario ipotetico collocato decenni nel futuro: potrebbe diventare realtà nel giro di pochi anni.

Leopold Aschenbrenner definisce questa prospettiva situational awareness, ovvero la capacità di riconoscere la direzione reale in cui sta andando la tecnologia, basandosi su segnali empirici, e comprendere che l’AGI potrebbe arrivare ben prima di quanto le istituzioni siano pronte ad affrontare. Il suo argomento centrale è che l’AGI non è un obiettivo teorico futuro, ma un punto di svolta imminente che influenzerà in modo significativo l’economia, la sicurezza nazionale e la struttura del potere globale.

1. Perché l’AGI entro il 2027 è plausibile

Le leggi di scaling e i trend osservati

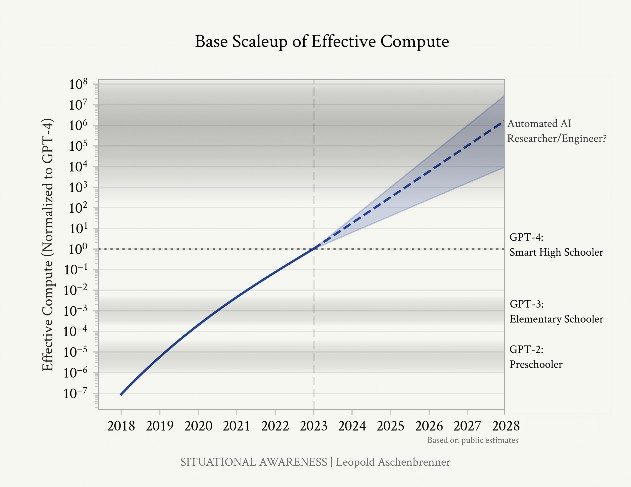

- Dal 2019 (GPT-2) al 2023 (GPT-4), i modelli linguistici di grandi dimensioni sono passati dalla generazione di testi basilari (e spesso imprecisi) a prestazioni da esperto in molteplici compiti accademici e professionali complessi, inclusi diversi test standardizzati e benchmark di programmazione.

- Questi miglioramenti non derivano da scoperte teoriche fondamentali, ma da un aumento sistematico della potenza computazionale, della dimensione dei modelli, dell’uso di dataset più raffinati e di tecniche di addestramento ottimizzate.

- Questo schema segue un insieme di “leggi di scaling”, che mostrano come le prestazioni dei modelli migliorino in modo prevedibile con l’aumentare della potenza di calcolo e dei dati.

- Aschenbrenner sostiene che, se queste tendenze continueranno, i modelli del 2027 potranno raggiungere o superare le capacità dei migliori esperti umani in molti ambiti—soddisfacendo di fatto una definizione funzionale di AGI.

La computazione effettiva crescerà di 100x–1000x

- La potenza di calcolo usata per addestrare i modelli più avanzati è cresciuta a un ritmo di circa 0,5 OOM (ordini di grandezza) all’anno—pari a un incremento di circa 10× ogni anno—superando di gran lunga la legge di Moore.

- Gli investimenti pubblici e privati in cluster GPU e infrastrutture di data center stanno accelerando. Entro il 2027, i modelli potrebbero beneficiare di ulteriori 2–3 OOM, pari a un aumento di 100–1000× della potenza computazionale effettiva.

Efficienza algoritmica

- Nell’ultimo decennio, molteplici miglioramenti algoritmici hanno ridotto significativamente la quantità di calcolo necessaria per ottenere determinati livelli di prestazione—con riduzioni anche di diversi ordini di grandezza. Questi miglioramenti derivano da innovazioni nei metodi di training, nelle architetture dei modelli, nell’uso dei dati e nelle tecniche di ottimizzazione.

- Aschenbrenner stima che potremmo assistere ad altri 1–3 OOM di miglioramenti nell’efficienza entro la fine del decennio. Questi progressi non solo potenzieranno le capacità offerte dall’hardware, ma moltiplicheranno anche gli effetti dello scaling computazionale. In altre parole, anche senza rivoluzioni infrastrutturali, algoritmi più intelligenti potrebbero portare le prestazioni nell’ambito AGI.

Lo “sblocco” dei modelli

- Molti modelli attuali sono limitati artificialmente da prompt poco sofisticati, contesti ridotti e strumenti limitati.

- Tecniche come il reinforcement learning da feedback umano (RLHF), l’uso di strumenti esterni, l’impiego di agenti e il ragionamento su contesti lunghi aumentano in modo significativo le capacità pratiche del modello, senza bisogno di aumentarne la dimensioni.

- “Sbloccare” i modelli e utilizzarli come agenti permette di ottenere una maggiore utilità nel mondo reale con le stesse capacità di base.

In sintesi: se le attuali tendenze nello scaling continueranno, e con le tecniche di ottimizzazione già disponibili, sarà possibile raggiungere l’AGI entro il 2027.

2. L’esplosione dell’intelligenza

Cosa succederà dopo l’AGI?

- Una volta che i sistemi di IA raggiungeranno un livello ci intelligenza comparabile ai migliori ricercatori umani, potranno essere impiegati direttamente nella ricerca e sviluppo dell’IA, agendo sia come collaboratori che come strumenti per accelerare l’innovazione.

- Questi sistemi saranno in grado di analizzare risultati sperimentali, generare nuove idee, ottimizzare le architetture e condurre simulazioni su larga scala con velocità e scala senza precedenti.

- Questo crea un ciclo di miglioramento continuo, in cui IA avanzate aiutano a progettare IA ancora più potenti, migliorando rapidamente le capacità ad ogni iterazione.

- Questa dinamica di auto-miglioramento potrebbe portare a una vera e propria “esplosione dell’intelligenza”, in cui i sistemi di IA superano rapidamente il livello umano in un’ampia gamma di ambiti: scientifici, strategici e tecnici.

Milioni di scienziati IA paralleli e accelerati

- In un mondo post-AGI, le organizzazioni potrebbero impiegare milioni di copie di AGI in parallelo, in cui ciascuna copia opera a velocità superiori a quelle umane.

- Questo equivarrà a disporre di una potenza di ricerca centinaia di volte più ampia e veloce di qualsiasi comunità scientifica umana mai esistita.

- Secondo Aschenbrenner, ciò potrebbe comprimere un decennio di progresso algoritmico in meno di un anno.

La superintelligenza non è lontana

- Secondo diversi scienziati, una volta raggiunta l'AGI basterà oltrepassare di pochi ordini di grandezza la potenza computazionale e l’efficienza algoritmica per produrre sistemi di intelligenza artificiale significativamente superiori a qualunque essere umano in termini di capacità cognitiva e risoluzione di problemi complessi.

- Tali sistemi potranno risolvere sfide scientifiche, ottimizzare strategie complesse e sviluppare nuove tecnologie con un’efficienza inarrivabile per l’uomo.

- Questo divario tra AGI e superintelligenza artificiale non va inteso come un processo che avrà bisogno di decenni per avverarsi: secondo le stime di Aschenbrenner, potrebbe concretizzarsi nel giro di mesi o pochi anni.

Se l’AGI arriva entro il 2027, la superintelligenza potrebbe seguire prima del 2030.

3. Le implicazioni geopolitiche

Una nuova corsa agli armamenti

- Le implicazioni della superintelligenza artificiale vanno oltre la tecnologia: potrebbero determinare chi deterrà il controllo geopolitico globale nei decenni a venire.

- Un vantaggio anche solo di 1–2 anni nello sviluppo e nella distribuzione di sistemi superintelligenti potrebbe garantire una supremazia decisiva a livello militare, economico, informativo e cibernetico.

- Un simile vantaggio strategico sarebbe difficile da colmare, soprattutto in un contesto competitivo e ad alta posta in gioco.

Lezioni dalla storia

- I conflitti militari del passato dimostrano l’impatto della superiorità tecnologica: la Guerra del Golfo ha mostrato come decenni di progresso tecnologico possano annientare un esercito numericamente superiore in pochi giorni.

- Secondo Aschenbrenner, dinamiche simili si applicheranno all’intelligenza artificiale, ma con conseguenze potenzialmente globali e su scala esponenziale.

La posta in gioco per il mondo libero

- Se saranno le democrazie a guidare la transizione verso l’AGI, sarà possibile impostare regole condivise per uno sviluppo sicuro, applicare standard di allineamento e costruire strutture di governance internazionale.

- Al contrario, se un regime autoritario come il Partito Comunista Cinese dovesse ottenere la leadership, aumenterebbero le probabilità di sorveglianza capillare, repressione politica e instabilità globale.

- Aschenbrenner sostiene che la leadership statunitense sia fondamentale non solo per la sicurezza strategica, ma anche per mantenere aperta la possibilità di un’implementazione responsabile e allineata dell’AGI a livello mondiale.

“La superintelligenza è una questione di sicurezza nazionale, e gli Stati Uniti devono vincere.”

4. Cosa deve succedere

Gli attuali standard di sicurezza non sono adeguati

- I principali laboratori di IA oggi operano con standard di sicurezza informatica inadeguati rispetto alla sensibilità delle tecnologie che sviluppano.

- I pesi dei modelli, i dataset di training e i documenti di ricerca—spesso del valore di centinaia di milioni di dollari—sono conservati in ambienti vulnerabili e non sufficientemente protetti.

- Questi asset sono esposti al rischio di furto da parte di attori statali, criminali informatici o insider, con implicazioni gravi sia sul piano della proprietà intellettuale che sulla proliferazione incontrollata di modelli potenti.

- È urgente un cambiamento verso standard di sicurezza equivalenti a quelli impiegati in ambito militare, con infrastrutture protette, controlli rigorosi sugli accessi, monitoraggio attivo e collaborazione sistematica con le agenzie di sicurezza nazionale.

Il futuro “Progetto Manhattan” dell’AGI

- Man mano che ci si avvicina all’AGI, è probabile che il governo degli Stati Uniti assuma un ruolo sempre più diretto nella supervisione dello sviluppo dell’IA di frontiera.

- Aschenbrenner prevede la creazione di un’iniziativa nazionale centralizzata, ispirata al Progetto Manhattan, per completare e distribuire in sicurezza l’AGI.

- Un tale sforzo richiederà strutture sicure, collaborazione inter-agenzia, reclutamento dei migliori talenti e finanziamenti su scala plurimiliardaria.

“Nessuna startup può gestire la superintelligenza.”

5. La situational awareness è rara

- Nonostante le evidenze e le implicazioni strategiche, la maggior parte delle istituzioni e dei decisori rimane impreparata rispetto alla velocità con cui l’IA sta progredendo.

- Anche nel settore tecnologico, molti leader continuano a considerare l’AGI come un obiettivo remoto o speculativo, sottovalutando la traiettoria attuale.

- Il messaggio centrale di Aschenbrenner è che lo sviluppo dell’IA nel prossimo decennio sarà estremamente rapido e trasformativo. Solo chi ha la consapevolezza della direzione dei trend in corso potrà prepararsi adeguatamente.

Citazioni (liberamente tradotte dal testo in inglese)

"È plausibile che entro il 2027 i modelli saranno in grado di svolgere il lavoro di un ricercatore o ingegnere di IA. Non serve credere nella fantascienza; basta credere nelle linee rette su un grafico."

"Guarda. I modelli vogliono solo imparare. Devi capirlo. I modelli vogliono solo imparare." – Ilya Sutskever (circa 2015, riportato da Dario Amodei)

"Dieci anni fa, i modelli a malapena riuscivano a riconoscere immagini semplici di gatti e cani; quattro anni fa, GPT-2 a malapena riusciva a comporre frasi vagamente plausibili. Ora stiamo rapidamente saturando tutti i benchmark che riusciamo a immaginare. Eppure questo progresso drammatico è stato semplicemente il risultato di tendenze ricorrenti nello scaling del deep learning."

"Stiamo attraversando gli ordini di grandezza (OOM) a velocità impressionante [...]. L’inferenza è semplice, ma l’implicazione è netta. Un altro balzo di quel tipo potrebbe portarci all’AGI, a modelli intelligenti quanto dottorandi o professionisti esperti, capaci di lavorare al nostro fianco. E forse più importante ancora: se questi sistemi potessero automatizzare la ricerca sull’IA stessa, si innescherebbero cicli di feedback molto intensi."

"Se continui a sorprenderti delle capacità dell’IA, inizia a contare gli ordini di grandezza."

"Una volta ci volevano decenni per superare benchmark ampiamente usati; ora sembra questione di pochi mesi."

"Se c’è una lezione che abbiamo imparato nell’ultimo decennio dell’IA, è che non si dovrebbe mai scommettere contro il deep learning."

"Con ogni ordine di grandezza di computazione effettiva in più, i modelli migliorano in modo prevedibile e affidabile. Se contiamo gli OOM, possiamo (in modo approssimativo e qualitativo) estrapolare i miglioramenti nelle capacità. È così che alcuni individui lungimiranti hanno previsto l’arrivo di GPT-4."

"[...] La conclusione è chiara: stiamo attraversando gli OOM molto rapidamente. Ci sono potenziali ostacoli nel limite dei dati [...], ma nel complesso, sembra probabile un altro salto delle dimensioni di quello tra GPT-2 e GPT-4 entro il 2027."

"C’è la possibilità reale che incontreremo dei blocchi sul percorso [...]. Ma penso sia ragionevole supporre che i laboratori riusciranno a superare gli ostacoli, e che ciò non solo manterrà attive le curve di scaling, ma potenzialmente abiliterà ulteriori miglioramenti nelle capacità dei modelli."

"Lo scaling delle tecniche di deep learning ha funzionato; i modelli vogliono solo imparare, e ci stiamo preparando per un ulteriore incremento di 100.000 volte entro il 2027. Presto saranno più intelligenti di noi."

"Il progresso dell’IA non si fermerà al livello umano. Centinaia di milioni di AGI potrebbero automatizzare la ricerca sull’IA, comprimendo un decennio di progresso algoritmico (5+ OOM) in un solo anno. Per questo motivo potremmo passare rapidamente da un’IA di livello umano a sistemi vastamente più intelligenti – in pratica, superumani."

"Una macchina ultraintelligente può essere definita come una macchina capace di superare di gran lunga tutte le attività intellettuali svolte da qualsiasi uomo, per quanto intelligente. Poiché la progettazione di macchine è una di queste attività, una macchina ultraintelligente potrebbe progettare macchine ancora migliori; innescando così un’‘esplosione d’intelligenza’, e l’intelligenza dell’uomo sarebbe irrimediabilmente superata. Dunque, la prima macchina ultraintelligente sarà l’ultima invenzione che l’uomo dovrà mai fare." – I. J. Good (1965)

"Dopo aver inizialmente imparato dalle migliori partite umane, AlphaGo ha iniziato a giocare contro sé stesso [...] e rapidamente è diventato superumano, sviluppando mosse estremamente creative e complesse che nessun umano avrebbe mai immaginato."

"Una volta raggiunta l’AGI, non avremo solo un’AGI. [...] Considerando le flotte di GPU per l’inferenza disponibili a quel punto, probabilmente saremo in grado di farne girare milioni [...]."

"Raggiunta l’AGI [...], i sistemi di IA diventeranno superumani—di gran lunga superumani. Diventeranno qualitativamente più intelligenti di me o di te, molto più intelligenti, forse come noi lo siamo rispetto a un bambino delle elementari."

"La ricerca sull’IA, una volta automatizzata, potrebbe comprimere un decennio umano di progresso algoritmico in meno di un anno (e questa stima è forse prudente)."

"La superintelligenza potrebbe offrire un vantaggio militare decisivo e scatenerebbe poteri distruttivi incalcolabili. Ci troveremo di fronte a uno dei momenti più intensi e instabili della storia umana."

"Potremmo assistere a tassi di crescita economica del 30% all’anno o più, forse anche a raddoppi multipli nel giro di un anno. Questo segue logicamente dai modelli economici standard di crescita."

"Storicamente, il potere militare e il progresso tecnologico sono sempre stati strettamente legati, e con un progresso tecnologico straordinariamente rapido arriveranno inevitabilmente rivoluzioni in campo militare."

"Gli ostacoli esistenti alla costruzione di data center da migliaia di miliardi di dollari negli Stati Uniti sono interamente autoimposti. [...] I cluster si possono costruire negli Stati Uniti, e dobbiamo darci una mossa per fare in modo che succeda. La sicurezza nazionale americana deve venire prima di tutto [...]. Se le imprese americane saranno liberate dai vincoli, potranno costruire meglio di chiunque altro (almeno negli stati repubblicani)."

"Dobbiamo prepararci al fatto che i nostri avversari potrebbero “rendersi conto dell’AGI” nei prossimi anni. L’IA diventerà la priorità numero uno di ogni agenzia di intelligence al mondo. In quel contesto, saranno disposti a usare mezzi straordinari e a pagare qualsiasi prezzo per infiltrarsi nei laboratori di IA."

"Il progetto tedesco aveva ristretto la scelta a due possibili materiali moderatori: la grafite e l’acqua pesante. [...] Poiché Fermi aveva mantenuto segreto il suo risultato, i tedeschi non avevano i suoi dati per effettuare controlli incrociati e correggere l’errore. Questo fu cruciale: li portò a puntare sull’acqua pesante, una scelta sbagliata che compromise definitivamente il loro sforzo per costruire la bomba atomica."

"[...] Ci troveremo in una situazione in cui, nel giro di meno di un anno, passeremo da sistemi di livello umano [...] a sistemi che ci sembreranno molto più alieni, enormemente superumani, e che porranno un problema di allineamento tecnico radicalmente diverso e fondamentalmente nuovo."

"[...] Mi aspetto che entro pochi anni questi sistemi di IA saranno integrati in molti sistemi critici, inclusi quelli militari (non farlo significherebbe lasciare il dominio completo agli avversari). Sembra folle, ma ricordate quando tutti dicevano che non avremmo mai collegato l’IA a internet? Lo stesso accadrà con affermazioni come “ci sarà sempre un umano nel processo decisionale!”."

"Quello che rende tutto questo davvero inquietante è la possibilità di un’esplosione d’intelligenza: potremmo passare da sistemi grossomodo a livello umano a sistemi enormemente superumani in modo estremamente rapido, forse in meno di un anno."

"La superintelligenza sarà la tecnologia—e l’arma—più potente che l’umanità abbia mai sviluppato. Darà un vantaggio militare decisivo, forse paragonabile solo alle armi nucleari."

"La nostra generazione dà troppo per scontata la possibilità di vivere in pace e libertà. E coloro che celebrano l’era dell’AGI nei racconti di fantascienza troppo spesso ignorano l’elefante nella stanza: la superintelligenza è una questione di sicurezza nazionale, e gli Stati Uniti devono vincere."

"In gioco non c’è solo un vantaggio in qualche guerra lontana, ma la possibilità stessa che libertà e democrazia possano sopravvivere nel prossimo secolo e oltre."

"Il mondo libero deve prevalere sulle potenze autoritarie in questa corsa."

"[...] Un vantaggio solido ci darebbe margine di manovra: la possibilità di “spendere” parte del vantaggio, se necessario, per trovare un modo per assicurare la sicurezza di questa tecnologia."

"La Sicurezza Nazionale entrerà in gioco [...]. Entro il 2027/28 avremo qualche forma di progetto governativo sull’AGI."

"Nessuna startup può gestire la superintelligenza."

"Se il progetto governativo è inevitabile, allora è meglio che cominci prima."

"Ora tutto questo mi sembra estremamente concreto. Posso vederlo. Posso vedere come verrà costruita l’AGI. [...] Posso dirti su quale cluster verrà addestrata l’AGI, quando sarà costruito, la combinazione approssimativa degli algoritmi che useremo, i problemi ancora irrisolti e la strada per risolverli, e l’elenco delle persone che saranno decisive in tutto questo. Riesco a vederlo."

"Domineremo la superintelligenza, o sarà lei a dominare noi? L’umanità eviterà ancora una volta l’autodistruzione? La posta in gioco è questa."